Qu’est-ce qu’un fichier robots.txt ?

Un fichier robots.txt est un fichier stocké dans le répertoire d’un site Web qui indique aux robots d’exploration les pages ou fichiers auxquels ils peuvent accéder. Ce fichier fonctionne comme un ensemble d’instructions qui permet aux éditeurs de sites Web de contrôler la façon dont les moteurs de recherche et autres bots interagissent avec leurs sites.

Pourquoi les fichiers robots.txt sont importants

Un fichier robots.txt a un impact direct sur l’optimisation pour les moteurs de recherche (SEO) des entreprises et sur le classement des pages Web dans les résultats de recherche. Les robots d’exploration légitimes consultent le fichier robots.txt chaque fois qu’ils explorent et indexent du contenu. Certains moteurs de recherche populaires comme Googlebot incluent également un « crawl budget » ou « budget de crawl », qui est directement influencé par le fichier robots.txt. Le budget de crawl fait référence au nombre de pages qu’un web scraper peut indexer sur une période donnée. Puisqu’un site web peut avoir un nombre de pages supérieur à son budget de crawl, les fichiers robots.txt permettent aux entreprises d’explorer leurs pages les plus importantes en priorité, en excluant les pages en double ou celles qui ne sont pas accessibles au public.

Les bots de scraping malveillants ne suivent pas les directives des fichiers robots.txt et tentent souvent d’accéder à des parties des sites web interdites aux robots. Considérez les fichiers robots.txt comme des lignes rouges qui imposent des limites aux bots légitimes. Bien que vous puissiez suivre ces directives, le fait de s’en affranchir n’est qu’une question d’éthique et les règles du fichier robots.txt ne vous empêchent aucunement de le faire. Les applications exécutent généralement d’autres outils de sécurité qui leur permettent de renforcer leur niveau de protection et les répertoires ou fichiers confidentiels qu’elles contiennent. De nombreux outils de sécurité surveillent attentivement les fichiers robots.txt étant donné qu’ils peuvent être utilisés comme « honeypots » (c’est-à-dire des leurres) pour détecter rapidement les bots malveillants sur leurs applications !

Comment créer un fichier robots.txt

Il y a quelques points à prendre en compte pour créer un fichier robots.txt :

Le fichier doit être situé à la racine du domaine, et chaque sous-domaine doit avoir son propre fichier.

Le protocole robots.txt est sensible à la casse.

Il est très facile de bloquer tout type d’exploration par erreur, alors assurez-vous de bien comprendre la syntaxe d’une commande avant de l’utiliser :

Disallow: / signifie tout interdire.

Disallow: signifie ne rien interdire, ce qui autorise tout type d’exploration.

Allow: / signifie tout autoriser.

Allow: signifie ne rien autoriser, ce qui bloquera tout type d’exploration.

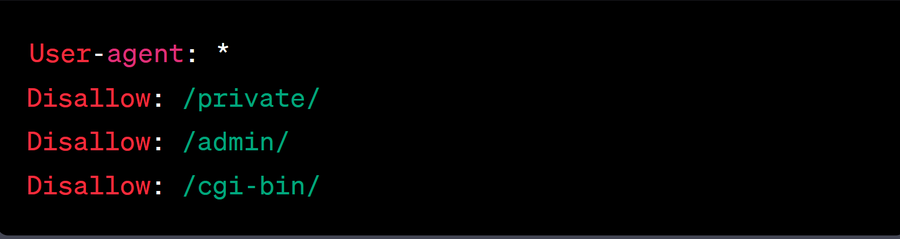

Voici un exemple de fichier robots.txt basique :

Dans cet exemple, l’astérisque (*) du champ "User-agent" indique que les règles s’appliquent à tous les robots web. Le code "Disallow" indique les fichiers ou répertoires que les robots ne doivent pas explorer, tandis que "/private/", "/admin/" et "/cgi-bin/" sont les répertoires non autorisés. En utilisant cette logique, les admins peuvent définir clairement les endroits que les bots ne doivent pas explorer, tout en ayant la possibilité d’étendre cette zone à tous les fichiers ou répertoires voulus.

Le fichier robots.txt permet aux entreprises de choisir les pages qu’un robot peut explorer, bien que cela puisse aussi ralentir le robot. Le crawl-delay est une directive non officielle qui permet aux entreprises de limiter le nombre de requêtes effectuées par un robot d’exploration sur une période donnée. Cette directive empêche les robots d’exploration de surcharger un serveur, et elle peut être définie pour un seul robot ou pour tous ceux qui la prennent en charge. Bien que cette règle non officielle soit suivie par certains moteurs de recherche comme Yahoo et Bing, d’autres moteurs (comme Googlebot) doivent être configurés à partir de leur propre console pour obtenir le même résultat.

Résumé

Les éditeurs de sites Web créent un fichier robots.txt pour guider les bots sur leurs applications. Bien que les bots légitimes utilisent ces informations pour savoir quelles pages ils peuvent explorer, les bots de scraping malveillants ne suivent aucune règle et explorent tout ce qu’ils souhaitent. Apprenez-en davantage sur les types de bots visés par les fichiers robots.txt ici.